[연구윤리, 통계, Ethics] Don't worry, P-hacking (걱정하지마, P해킹이 있잖아)

출처: Pixabay

저작권: Creative Commons 0

"아, 이번 데이터는 유의한 결과를 뽑을 수 있을줄 알았는데, 어떡하지? 연구 다시 해야하나?"

"걱정마, P-hacking이 있잖아 :)"

안녕하세요, @doctorbme 입니다. 연구를 수행할 때 데이터 수집, 가공, 분석에서 문제가 발생할 수 있습니다. 데이터 조작은 아니지만 애매하게 입맛대로 가공하는 것이지요. 오늘은 연구를 수행함에 있어서 윤리적으로 문제가 될 수도 있는 (확실히 문제가 된다고 이야기하기는 조금 애매할 수도 있기에 이렇게 표현합니다) P-hacking에 대해서 살펴보도록 하겠습니다.

P-hacking이란 간단하게 말하자면, 유의한 통계 수준 (P<0.05)를 얻기 위해서, 데이터 획득 과정에서 임의로 멈추거나 데이터 분석 방법을 임의대로 다양하게 변화시키거나, 혹은 데이터 구조를 변화시키는 것을 뜻합니다. 다시 말해, 데이터를 수집하거나 선택하거나 통계적으로 분석하는 과정에서 통계적으로 유의하지 않은 결과를 억지로 유의하도록 만드는 것을 뜻합니다.

이러한 상황은 왜 일어나게 되는 것일까요?

- 통계적으로 유의하지 않은 결과는, 결과로서 인정받지 못하고 저널에서 퍼블리쉬하기 어려움

- 기존의 결과를 재현하는 연구의 경우에도, 통계적으로 유의하지 않은 결론을 내리는 연구보다 통계적으로 유의한 결론을 내리는 연구가 인정 받음

- 기존의 가설에 따라 연구를 진행할 때, 통계적으로 유의하지 않은 것에 대해, 가설이 틀렸음으로 해석함

위와 같은 상황 때문에, 연구자들은 P-hacking의 유혹에 빠지게 됩니다.

저널을 출판할 때에는 아무래도 유의한 결론을 내리는 연구가 주목을 더 받게 되기 때문에 (어떠한 가설을 증명했다는 것이 결국 돋보이기 때문에) 저널 출판에 있어서도 출판 비뚤림, publication bias가 발생하게 됩니다. 이는 두 가지의 효과를 유도하게 되는데,

- 유의하지 않은 결과를 출판(발표)하지 않음

- P-hacking 혹은 선택적 리포팅을 통해, 잘못 유의하게 해석될 결과를 출판(발표)함

위와 같은 부정적인 효과를 낳을 수 있고, 이는 결국 다른 사람들의 후속 연구를 잘못된 방향으로 이끌거나 펀딩을 비롯한 자원의 낭비를 불러일으킬 수 있습니다.

이러한 P-hacking은 다음과 같은 구체적인 시도로 이루어질 수 있습니다.

- 데이터 수집 중간에 계속 분석을 시도하면서, 통계적으로 유의한 결과가 나타나는 순간 수집을 멈춤

- 최대한 많은 변수들을 우선 수집하고, 이 중에서 유의한 결과를 보이는 변수들을 선택적으로 뽑음 (미리 이러한 실험 설계를 세팅하지 않음)

- 우선 분석을 한 뒤에, 유의한 결과가 보이지 않는다면 이 때 이상치, outlier들을 버림 (미리 이러한 기준을 세우지 않음)

- 그룹별로 묶인 변수들에 대해서, 그룹 자체를 임의로 배제하거나 묶거나 나누거나 결합하여 유의한 결과를 도출

- 통계적으로 유의한 p-value를 얻고 나서 더이상 깊이 데이터 분석을 하지 않음

이러한 p-value는 사실 표본수에 영향을 받기 때문에, 매우 많은 샘플링을 하는 경우, 실제 유의하지 않은 결과가 통계적으로 유의하게 나올 수 있고, 그 반대도 가능합니다. 따라서 최근에는 p-value 대신 효과 크기(effect size)로 기술하려는 움직임도 나타나고 있습니다. 효과 크기를 사용하는 경우,

- 얼마만큼 차이 혹은 연관성이 있는지 수치로 보여줄 수 있으며

- 샘플 수에 대한 영향을 받지 않고

- 여러 형태의 결과 간 공통의 비교를 할 수 있도록 맞춘다

위와 같은 세 가지의 장점을 가지고 있습니다.

효과 크기의 가장 간단한 예로는,

두 집단의 평균을 비교하고자 하는 경우, 두 집단의 평균의 차(mean difference)를 우선 구하고, 이를 통합표준편차(pooled standard deviation)으로 나눈 값을 효과 크기로 사용하는 방법이 있습니다. 이 때 귀무가설은 효과크기=0이 되고, 두 집단의 평균의 차이가 클수록, 효과 크기도 커지게 될 것입니다.

P-hacking의 효과를 알아보기 위해서, p-curve라는 것을 도입할 수 있습니다. p-curve 는 여러 연구들의 p-value에 대한 분포를 나타낸 커브입니다. 이러한 p-curve를 통해서, 우리는 1) 출판 비뚤림의 영향과 2) P-hacking의 영향을 살펴볼 수 있습니다.

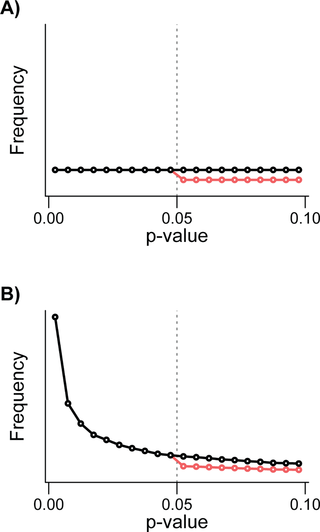

참고문헌[1]의 그림1. 출판 비뚤림(publication bias)의 효과를 나타냅니다.

저작권: CC-BY 4.0

- 귀무가설( null hypothesis)은 효과크기가 0인 가설을 나타냅니다. 이 경우, 샘플 수에 따라서 어떠한 p-value이든 균일하게 관찰될 수 있습니다. (그림 A의 검은 색) 하지만 p-value가 높은 결과를 출판하지 않을 경우, 0.05를 기준으로 (0.05를 넘어서면) 커브는 빨간색으로 변화하게 될 것입니다. 즉, p-value가 0.05보다 높은 리포트가 출판되는 횟수가 줄어듭니다.

- 만약 실제 효과크기가 0이 아닌 경우, 기존 연구들의 경우에도 대체로 p-value가 유의하게 나올 것입니다. (즉, 왼쪽이 높게 분포가 쏠릴 것입니다. 그림 B의 검은색) 하지만, 역시 출판 비뚤림으로 인해 0.05 이후에서 출판 횟수의 급격한 떨어짐(drop, discontinuity)이 관찰될 수 있습니다.

그렇다면 p-hacking의 효과는 어떨까요?

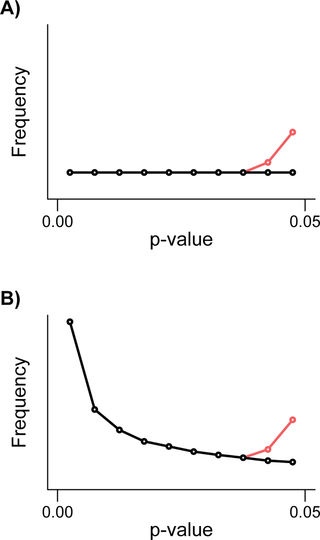

참고문헌[1]의 그림2. P-hacking 의 효과를 나타냅니다.

저작권: CC-BY 4.0

- 효과 크기가 0인 귀무가설이 지지되는 연구 결과의 경우, 저널에 출판되는 p-value의 분포는 균일해야하지만 (그림 A의 검은색), p-hacking이 일어나는 경우 0.05에 도달하기 전 부근에서 출판 횟수가 급격히 늘어날 것입니다. 그림A의 빨간색을 참고하세요. (왜냐하면 어찌되었든 통계적으로 유의한 결과를 만들어야 하니까요)

- 그러면 실제로 효과 크기가 존재하는 연구인경우에는 어떨까요, p-value가 작을수록 잘 리포트되고, 0.05에 가까울수록 떨어지겠지만, (그림B의 검은색) 0.05 근방에서 오히려 출판 횟수가 치고 올라올 것입니다. (그림B의 빨간색)

그러면 이러한 P-hacking을 방지하기위해서는 어떻게 해야할까요?

우선 연구자의 입장에서는

- 여러 변수들의 수집, 가공 과정이 미리 정해지고 결과에 따라서 변경되지 말아야 합니다. (혹은 합리적으로 변경되어야 합니다.)

- 중요한 변수들만이 측정되어야 하며, 충분히 적절한 샘플 사이즈를 마련해야 합니다.

- 통계적으로 유의한 결과보다 데이터 수집과 연구 방법론에 대한 강조가 필요합니다.

- 삼중 맹검법(Triple blind)이 필요할 수 있습니다. 데이터 처리 과정에서도 처리에 대한 blind를 하는 것입니다.

그리고 저널에서는 다음과 같은 사항을 강조하는 것이 좋겠습니다.

- 데이터 분석과 결과에 대한 전체적인 리포트: 분석 과정 전체와 효과 크기 등의 다양한 인덱스 포함

- P-hacking을 방지하기 위해, 연구 방법론에 대한 (연구 시행 전의) 확립

- 가능하다면 raw data에 대한 open access

- 통계적으로 유의하지 않은 결과 (negative results)에 대한 긍정적 인식과 출판 권장

이러한 방향이 중요할 것으로 보입니다.

P-hacking은 연구 부정까지 이야기하기에는 애매한 지점이 존재할 수 있습니다. 하지만 충분히 진실된 결과, 후속 연구의 방향이 제대로 이루어지기 위한 도움 닫기의 연구 결과를 나타내기 위해서는, 연구자들이 연구를 수행하면서 P-hacking에 관한 인식과 경각심을 한번쯤 가져보아야 하지 않을까 생각합니다.

참고문헌

[1] Megan L. Head , Luke Holman, Rob Lanfear, Andrew T. Kahn, Michael D. Jennions, The Extent and Consequences of P-Hacking in Science, PLoS Biol 13(3): e1002106. https://doi.org/10.1371/journal.pbio.1002106 , 저작권 CC-BY 4.0

[2] 남상건, 효과크기의 이해, Hanyang Med Rev 2015;35:40-43

[3] p-hacking, or cheating on a p-value, http://freakonometrics.hypotheses.org/19817

Congratulations @doctorbme! You have completed some achievement on Steemit and have been rewarded with new badge(s) :

Click on any badge to view your own Board of Honor on SteemitBoard.

To support your work, I also upvoted your post!

For more information about SteemitBoard, click here

If you no longer want to receive notifications, reply to this comment with the word

STOP각종단체에서 통계자료를 선택적으로 유리한것만 발표하는것도 P해킹이라 할수있을까요

선택적으로 유리한 자료를 바탕으로 다시 추가적으로 분석해서 (예를 들어 일종의 선택적인 자료만을 취합한 메타분석이 있을 수 있습니다), 유의한 p-value를 임의적으로 도출하면 p해킹에 가깝다고 봅니다. 발표 자체만을 놓고 본다면 출판 비뚤림에 가까울 것 같습니다. :)